クラウドに頼らないAI ― エッジAIを試してみた

温泉で滑って転んで怪我をしました。

この記事は、社内イベント「お茶会」での発表内容をもとにまとめたものです。

今回は弊社の takano が「エッジ AI」について話しました。

この数年で、画像生成や文章生成をはじめとする AI 技術が急速に広がり、Web サービスやアプリにも活用されるようになってきました。

しかし、実際に AI を導入しようとすると次のような課題があるように思います。

AI の処理には GPU を搭載した高性能なマシンが必要で、基本的には 1 台(1 GPU)につき 1 処理ずつしか実行できません。そのため、Web サービスのように複数のユーザーがアクセスする環境では、次のような問題が発生します。

- 処理中のユーザーに待ってもらう必要がある(遅延)

- サーバーの台数を増やして対応する必要がある(コスト増)

また、外部の AI サービスを API 経由で利用する方法も一般的になっていますが、これにも別の問題が。

- データを外部に送信する必要があり、プライバシー面での懸念がある

- リクエストごとに費用が発生するため、アクセス量によってコストが変動する

- 自分でトレーニングしたモデルを使いづらい

特に、アクセス数が読みにくいサービスではコスト見積もりが難しく、運用面での負担をどう抑えるかが検討課題です。

そうした状況の中で、「ユーザーの手元の端末で処理してしまえばいいのでは」という発想が生まれました。

近年は PC やスマートフォンの性能が大きく向上し、もはやちょっとしたサーバー並みです。

そこで注目されるようになったのが、エッジAI です。

01 エッジ AI とは

エッジAI とは、AI の処理をクラウド上ではなくユーザーの手元にあるデバイス(PC・スマートフォン・IoT 機器など)で実行する技術のことです。

その一例が、ブラウザ上で JavaScript などを使って AI を動かす仕組み。

ブラウザの中で AI モデルを読み込み、端末の CPU や GPU を使って推論を行います。

クラウドを経由しないため、次のようなメリットがあります。

- インフラコストがかからない

- ローカル完結でユーザーのデータは外部に送られないためプライバシーが守られる

- 低遅延での応答が可能(個人の端末性能に依存するが、今後さらに高性能になっていくと考えられる)

一方で、デメリットも存在します。

- バッテリー消費や発熱の増加

- モデルのダウンロードによる通信負荷

- AI モデルやコードをユーザー側に読み込ませる必要があり、その中身を確認できてしまう(一般的なフロントエンドの課題でもあるが、同じものが作れてしまう)

その中でも、個人的に特に大きいと感じているのがモデルのダウンロードの問題です。

ここからは、その点について少し掘り下げてみます。

モデルのダウンロード問題

AI を端末側で動かすためには、学習済みモデルをユーザーの環境に読み込ませる必要があります。

しかしこのモデルファイルが非常に大きく、それなりに良い LLM のもので 4GB 規模になることもあります。

モデルを端末に転送するだけで負荷が大きく、通信量も無視できません。

さらに、Web のキャッシュはサイト単位で管理されるため、同じモデルを使っていてもサイトが違えば再度ダウンロードが発生します。

複数サイトで展開する場合や、性能の低い端末では現実的ではありません。

加えて、配信元のサーバーでも転送料金が膨大になる可能性があります。

「どこにモデルを置き、どのように配信するのか」これがエッジAIを運用する上で避けて通れない問題です。

解決に向けて

通信量の課題を根本的に解決する方法は、まだ確立されていません。

ただし、いくつか現実的なアプローチが考えられます。

たとえば、Web ではなくネイティブアプリとして提供する方法です。

最近のゲームアプリのように大容量データが当たり前になっていることを考えると、数 GB のモデルでも受け入れられるかもしれません。

また、管理画面など特定のユーザーが使う場面では、ローカルにモデルをダウンロードしてもらい、利用のたびにそれを利用してもらう運用も考えられます。

ただし、利用頻度が限られている場合は、サーバー側で処理した方が合理的かもしれません。

また今後、Android や iOS に AI モデルがプリインストールされ、それを呼び出す API が標準化されることがあれば、大きなブレイクスルーになるでしょう。

IoT のように端末内部にモデルを組み込める環境では、すでにエッジAIと相性が良く、Raspberry Pi などの小型デバイスでも AI を動かすことができます。

このような構成を活かせば、IoT デモやおもちゃのような試作も手軽に行えるでしょう。

02 Google AI Edge

Google はクラウド上の AI サービスだけでなく、デバイス上で AI を動かすためのプラットフォーム「Google AI Edge」も提供しています。

その中でも特に今回紹介したいのが、LiteRT と MediaPipe という 2 つのランタイムです。

LiteRT

LiteRT は、一般的な AI モデルを軽量化し、ブラウザやスマートフォン上で動作させるための仕組みです。

既存の優秀な学習済みモデルを変換して利用できるため、特別な環境構築をしなくても、端末上で AI を実行できるのが特徴です。

また、LoRA(Low-Rank Adaptation)にも対応しています。

これは「既存モデルに追加の重みを足すことで、学習済みモデルを簡単にカスタマイズできる」アプローチで、製品説明の自動生成など、特定タスクに合わせた出力を調整する際に便利です。

LoRA を使えば、モデル全体を再学習させなくても、必要な部分だけを差し替えて使うことができます。

MediaPipe

もう一つの MediaPipe は、ウェブカメラなどを通じて映像から人の動きや物体を検出できるライブラリです。

手や顔の動きの認識だけでなく、LLM の推論やマルチモーダル処理にも対応しています。「マルチモーダル」とは、音声・映像・テキストなど異なる種類の情報を同時に扱う技術のこと。

これまでクラウドでしか実現できなかった高度な処理を、ブラウザ上で動かせるのが大きな特徴です。

Google はこれらの機能を体験できる MediaPipe Studio というデモサイトも公開しており、簡単に試せるようになっています。ぜひ遊んでみてください。

03 自作デモ

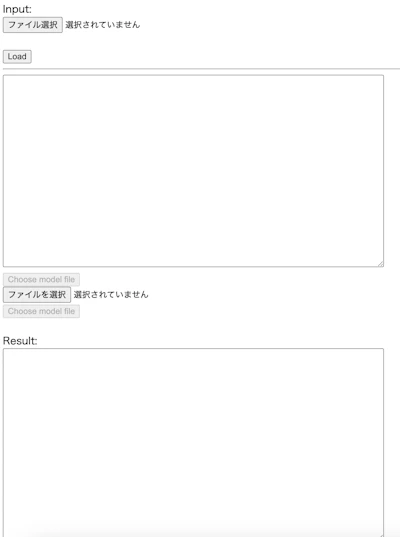

自分で簡単なデモも作ってみました。

今回は約 4GB のモデルをブラウザに読み込ませて動作を確認しました。

都度ダウンロードするのは現実的ではないため、ローカルに置いたファイルを読み込んでいます。

読み込みに少し時間はかかりましたが、完了後はすぐに動作しました。

上部のテキストボックスに指示を入力します。試しに今日の天気を聞いてみたところ、すぐに回答が返ってきました。

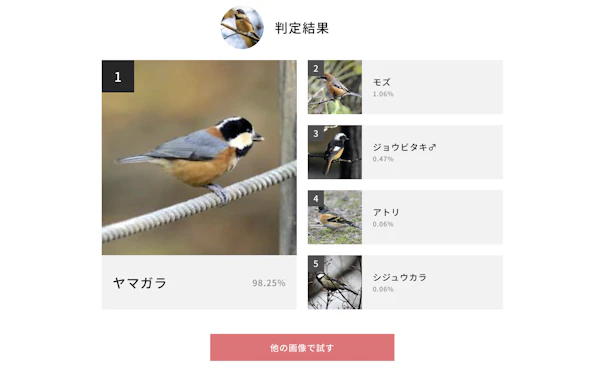

次に、下のみかんの画像を渡して画像認識をやってみます。

入力した内容は以下の通りです。

あなたは画像認識APIです。

次の形式でレスポンスしてください。

{

"result": true,

"score": 95

}

次の画像にミカンが写っていれば true を、写っていなければ false を返してください。

ミカンが写っていた場合は、写り方を 100 点満点で採点し、score として返してください。

ミカンが写っていると正しく判定され、スコアも返ってきましたね。

続いてレモンの画像を渡して、「false の場合は理由も返すように」と条件を加えてみました。

正しく判定できているようです。

他にも、画像にテキストが含まれている場合でも、それをしっかりと認識し、内容を抽出することができます。

さらに、画像の中の色を識別してカラーコードを判定することも可能でした。

このように、フロントエンド上だけでも想像以上に多くの処理が行えることがわかります。

04 LiteRTとONNX

LiteRT に変換することで、自分で作成したモデルもブラウザ上で動かせます。

一方で、ONNX(Open Neural Network Exchange)というオープンな活動もあり、

さまざまな形式のモデルを共通仕様で扱えるようにする取り組みが進んでいます。

ONNXに変換すると、JavaScript上でそのままモデルを動かすことが可能です。

システムとしては WebAssembly を利用しており、ブラウザ内で推論処理を実行できます。

つまり、トレーニング済みのモデルを変換して読み込むだけで、フロントエンドから AI を呼び出せるようになるということです。

自分でトレーニングしたモデルを使うこともできますが、MediaPipe のように使いやすいインターフェースは提供されていないため、ある程度の知識や環境構築が必要になります。

05 まとめ

エッジ AI にはまだ課題もありますが、管理画面などで AI を組み込んでみたいときに便利です。

MediaPipe などの機能は手軽に扱えるので、積極的に使っていける段階にあります。

まずは触ってみて、どんなことができるのかを確かめてみましょう。

AI を導入するときは、「サーバーで処理する」だけでなく、フロントエンドで実装するという選択肢も見えてきました。

ディレクションや設計の立場の方も、「この機能はフロントでエッジAIを使ったほうが早いかも」と判断できるくらいの理解を持っておくと、幅が広がると思います。

エッジ AI は知っておくだけでも、設計や提案の考え方を変えてくれる技術です。

まずは身近な場面から取り入れて、その可能性を試してみてください。

S2ファクトリー株式会社

様々な分野のスペシャリストが集まり、Webサイトやスマートフォンアプリの企画・設計から制作、システム開発、インフラ構築・運用などの業務を行っているウェブ制作会社です。

実績

案件のご依頼、ご相談、その他ご質問はこちらからお問い合わせください。